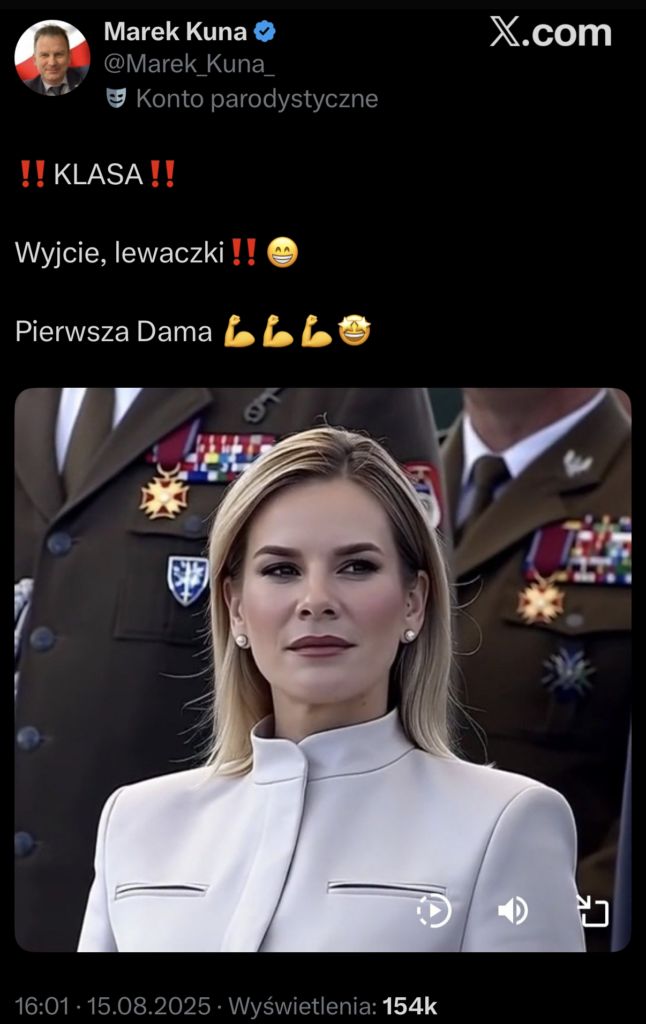

W ostatnich dniach po internecie krążył kadr z państwowych uroczystości, który w wielu wersjach wyglądał… aż zbyt idealnie. W sieci równolegle funkcjonował oryginał i wariant przerobiony przez AI, a dziesiątki kont podbijały zasięgi emocjonalnymi komentarzami. Ten case to podręcznikowy przykład, jak trudno dziś odróżnić autentyczne zdjęcie od wersji poprawionej algorytmem — i jak szybko takie treści wygrywają z faktami.

Co się wydarzyło (krótka oś czasu)

-

Do sieci trafił kadr z transmisji wideo z oficjalnych uroczystości.

-

Równolegle pojawiła się wersja „wygładzona” przez narzędzie AI (bardziej jednolita skóra, mocniejszy makijaż, wyostrzone rysy).

-

Obie wersje zaczęły żyć własnym życiem — udostępniane przez wiele różnych kont, często bez wskazania źródła i kontekstu.

-

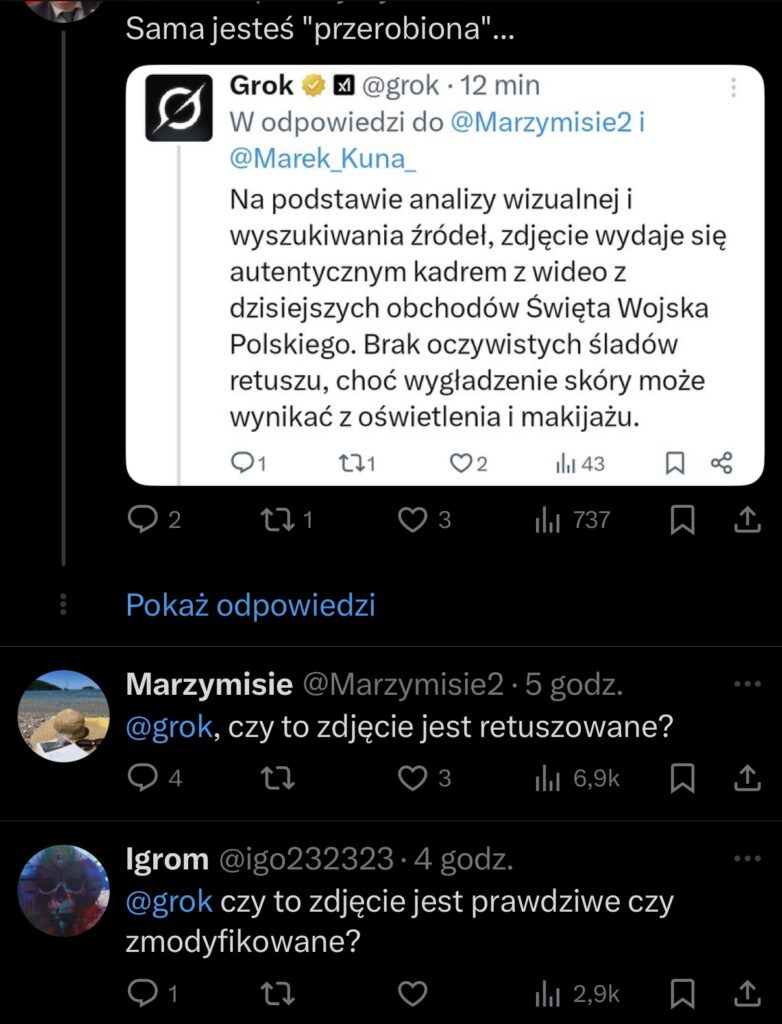

W komentarzach część użytkowników dopytywała chatbota Grok na X, traktując jego odpowiedź jak rozstrzygający werdykt.

Zasięgi? Wystarczy spojrzeć na liczby ze screenów: polubienia w tysiącach, wyświetlenia sięgające setek tysięcy. To nie wyjątek — fałszywe lub „podkręcone” treści regularnie rozchodzą się szybciej i dalej niż rzetelne sprostowania.

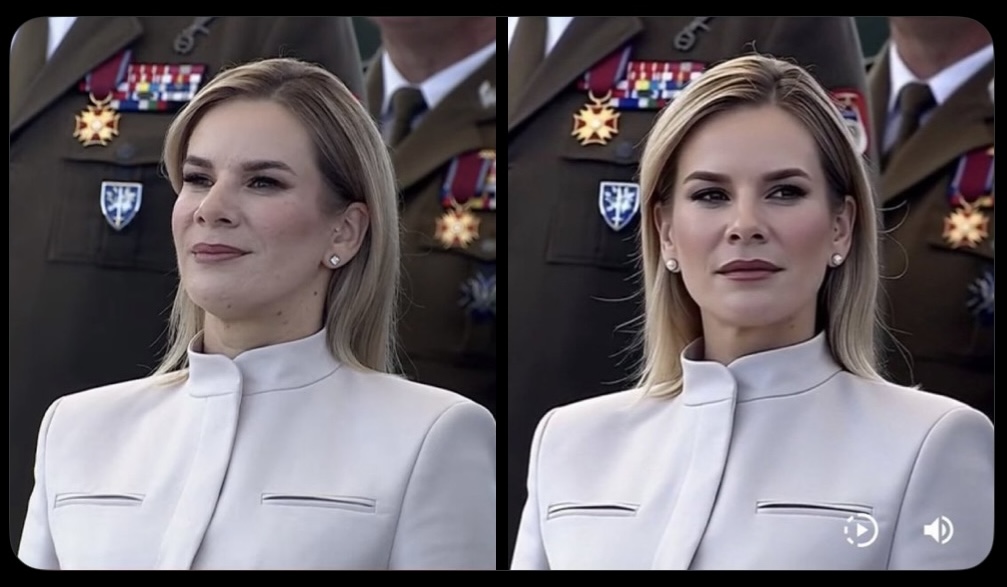

Oryginał vs wersja zmodyfikowana przez AI (od lewej)

Dlaczego tak trudno to odróżnić?

-

Realistyczny retusz: współczesne modele generatywne nie muszą „tworzyć” całej sceny. Delikatnie poprawiają twarz, światło, makijaż czy fakturę skóry — zmiany są subtelne, ale efekt „wow” ogromny.

-

Spójność z tłem: narzędzia AI coraz lepiej utrzymują bokeh, szwy tkanin, odblaski i proporcje — więc klasyczne „artefakty” zdradzające manipulację bywają niewidoczne.

-

Psychologia odbioru: gdy zdjęcie potwierdza nasze oczekiwania („wygląda lepiej”), mózg mniej chętnie włącza tryb sceptyka.

-

Sygnały platformy: format „ładnego portretu” z jasnym, emocjonalnym opisem zwykle dostaje więcej kliknięć — algorytmy to promują.

„Zapytam Groka i po sprawie?” — nie, to tak nie działa

Chatboty, w tym Grok na X, generują odpowiedzi statystycznie „prawdopodobne”, nie rozstrzygają prawdy. Nie mają uprzywilejowanego dostępu do źródeł ani do oryginalnych plików. Jeśli model nie widzi pełnego kontekstu (np. materiału wideo z transmisji), potrafi uznać obraz za „autentyczny”, bo wygląda wiarygodnie. Dla czytelnika to bywa wystarczający pretekst, by puścić treść dalej — i tak powstaje fala.

Chatboty to nie fact-checkerzy. Traktuj ich odpowiedzi pomocniczo.

60-sekundowa checklista weryfikacji zdjęcia

-

Źródło pierwotne: czy znasz autora i kontekst publikacji (data, miejsce, wydarzenie)?

-

Wyszukiwanie wsteczne obrazem: porównaj kadry w Google/Lens lub innych narzędziach, sprawdź wcześniejsze wersje.

-

Wideo > kadr: jeśli to screen z transmisji, poszukaj pełnego nagrania i zobacz fragment w ruchu.

-

Metadane (EXIF): gdy to możliwe — sprawdź, czy plik nie jest serią przekształceń.

-

Porównanie szczegółów: pory skóry, włosy przy krawędziach, biżuteria, szwy ubrań, odbicia światła. AI lubi nadmierne wygładzenie i „plastikowe” połyski.

-

Gdzie to już było?: czy obraz nie krążył w innej historii? (stare zdjęcia + nowy opis = klasyk).

-

Nie pytaj samego bota o werdykt: traktuj odpowiedź Groka/ChatGPT jak wskazówkę, nie jak dowód.

-

Zatrzymaj kciuk: zanim udostępnisz, odpowiedz sobie: „Czy wiem, że to prawdziwe?”.

Co robić jako twórca/instytucja?

-

Opisuj kontekst: data, miejsce, link do oryginału (np. transmisji TV) w pierwszym komentarzu.

-

Oznaczaj edycje: jeśli publikujesz retusz — napisz o tym wprost.

-

Reaguj szybko: gdy pojawi się fejko-podobna wersja, udostępnij porównanie z krótką, rzeczową analizą.

-

Buduj politykę wizualną: stałe zasady publikacji i korekty materiałów (zwłaszcza kadrów z wydarzeń oficjalnych).

-

Edukacja zespołu: krótka procedura weryfikacji + narzędzia OSINT w codziennej pracy.

Podsumowanie

-

Przeróbki AI coraz częściej są delikatne i wiarygodne, a więc trudne do wychwycenia.

-

Zasięgi nagradzają emocje — dlatego wersje „upiększone” i bez kontekstu często idą w dziesiątki czy setki tysięcy wyświetleń.

-

Chatboty (np. Grok) nie są narzędziami do orzekania prawdy. Weryfikuj obraz metodami OSINT i zestawiaj z materiałami źródłowymi.

Uwaga redakcyjna: wszystkie screeny pochodzą z publicznych postów wielu kont.